Szesnaście twarzy wyrażających ludzkie namiętności – rycina kolorowa J. Passa, 1821, wg Charlesa Le Bruna. From Wikimedia Commons, the free media repository.

Streszczenie

Od dawna stawiano hipotezę, że istnieje wiarygodne, specyficzne odwzorowanie pomiędzy pewnymi stanami emocjonalnymi a ruchami twarzy, które je wyrażają. Hipotezę tę często testuje się, prosząc nieprzeszkolonych uczestników, aby podczas ogólnych scenariuszy ułożyli ruchy twarzy, których ich zdaniem używają do wyrażania emocji. Tutaj testujemy tę hipotezę, używając jako bodźców zdjęć konfiguracji twarzy pozowanych przez profesjonalnych aktorów w odpowiedzi na bogate kontekstowo scenariusze. Scenariusze przedstawione na zdjęciach zostały ocenione przez wybraną próbkę uczestników pod kątem stopnia, w jakim przywołują wystąpienie 13 kategorii emocji, a pozy twarzy aktorów zostały zakodowane pod kątem ich konkretnych ruchów. Zarówno uczenie maszynowe bez nadzoru, jak i nadzorowane odkryło, że na tych zdjęciach aktorzy przedstawiali stany emocjonalne przy zmiennych konfiguracjach twarzy; przypadki tylko trzech kategorii emocji (strachu, szczęścia i zaskoczenia) zostały przedstawione z umiarkowaną wiarygodnością i swoistością. Inna próba uczestników oceniała oddzielnie zdjęcia pod kątem stopnia, w jakim przedstawiały wystąpienie 13 kategorii emocji; oceniano je, gdy były prezentowane samodzielnie oraz wraz z powiązanymi z nimi scenariuszami, co ujawniło, że wnioski dotyczące emocji dokonywane przez uczestników również różnią się w zależności od kontekstu. Łącznie odkrycia te sugerują, że ruchy twarzy i postrzeganie emocji różnią się w zależności od sytuacji i wykraczają poza stereotypy dotyczące ekspresji emocjonalnej. Przyszłe badania mogą opierać się na tych ustaleniach, włączając bodźce dynamiczne zamiast fotografii i badając szerszy zakres kontekstów kulturowych.

Podobne treści oglądane przez innych

s41467-021-25352-6

Wstęp

Różne ramy teoretyczne w nauce o emocjach – w tym podejścia konstrukcjonistyczne1,2,3,4, funkcjonalistyczne5,6 i ekologia behawioralna7 – zakładają, że ludzie wyrażają przypadki emocji w sposób specyficzny dla sytuacji. Przewidują one znaczną zmienność ruchów twarzy, które są używane do wyrażania gniewu, strachu i innych kategorii emocji, a także brak specyficzności w przypadku różnych kategorii. Nazywamy to hipotezą wrażliwości na kontekst. Przewiduje się, że wyrażanie tej samej kategorii emocji będzie mniej wiarygodne i specyficzne w różnych przypadkach, ponieważ ruchy twarzy w każdym przypadku są dostosowane do bezpośredniego kontekstu, tak jak w przypadku wszystkich ruchów motorycznych8. Kontekst obejmuje cechy zewnętrzne (np. czy dana osoba jest w pracy lub w domu, kto jeszcze jest obecny, jakie były ostatnie działania danej osoby itp.), a także cechy wewnętrzne (np. stan metaboliczny danej osoby, cele w chwili obecnej, przeszłe doświadczenia itp.) Uważa się, że te czynniki kontekstowe stwarzają możliwość znacznej zmienności wewnątrzkategorialnej w wyrażaniu emocji (np. osoba może marszczyć brwi, rozszerzać oczy, a nawet śmiać się, gdy jest zła), a także podobieństw między kategoriami w ruchach twarzy wyrażających emocje (np. grymas może wyrażać złość w niektórych kontekstach, koncentrację w innych). Hipoteza ta nie została jeszcze przetestowana w badaniu, które zostało wyraźnie zaprojektowane w celu zaobserwowania ustrukturyzowanej zmienności, jeśli jest ona obecna.

Zamiast tego większość opublikowanych badań kierowała się hipotezą, że przypadki gniewu, smutku, szczęścia i niektórych innych kategorii emocji mają jednoznacznie identyfikowalne wyrazy twarzy, które są uniwersalne we wszystkich kulturach ludzkich (np. uśmiechanie się w szczęściu, szyderstwo w gniewie, marszczenie brwi w smutku). Hipoteza ta odpowiada podejściu do zrozumienia emocji znanemu jako podstawowy pogląd na emocje9,10,11,12, zgodnie z którym uważa się, że pewne kategorie emocji rozwinęły określone prototypowe konfiguracje ruchów twarzy, które wyrażają i komunikują ich instancje13. W typowym badaniu zaprojektowanym w celu przetestowania tej hipotezy, nieprzeszkoleni uczestnicy otrzymują pojedynczy zubożony scenariusz, który jest uważany za reprezentatywny dla danej kategorii emocji (np. „Zostałeś obrażony i jesteś bardzo zły z tego powodu „9) i są proszeni o pozowanie konfiguracji twarzy, którą uważają za wyrażającą tę emocję9,14,15. Takie podejście ogranicza możliwość odkrycia ekspresyjnej zmienności poprzez zachęcanie uczestników do wykonywania stereotypowego zestawu ruchów twarzy.

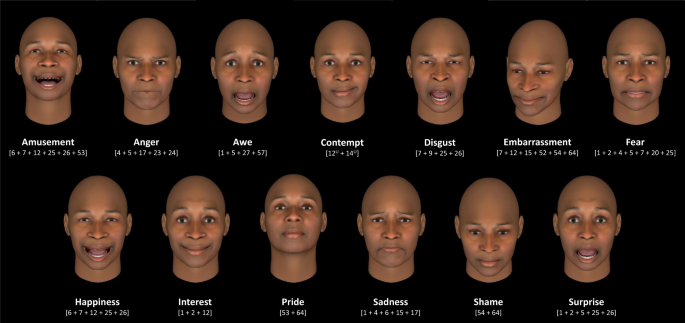

Podstawowa hipoteza emocji nie sugeruje, że każda osoba wyraża każdą instancję danej kategorii emocji za pomocą dokładnie takich samych ruchów mięśni twarzy – oczekuje się pewnej zmienności wokół każdego hipotetycznego prototypu (na przykład patrz Tabela uzupełniająca 1). Niemniej jednak zakłada się, że instancje są wyrażane za pomocą konfiguracji twarzy o wystarczającej niezawodności i specyficzności, aby można było z dużą pewnością wnioskować o stanach emocjonalnych ludzi na podstawie ich ruchów twarzy. Na przykład, podstawowy pogląd na emocje zakłada, że nie wszyscy ludzie wzdrygają się w gniewie przy każdej okazji, ale że ludzie wzdrygają się, gdy są źli, na tyle niezawodnie i konkretnie, że można wywnioskować, że dana osoba jest zła, gdy się wzdryga. Podobna hipoteza istnieje dla ponad 20 różnych kategorii emocji9,12, chociaż większość opublikowanych badań koncentruje się na mniejszej liczbie kategorii. Rysunek 1 przedstawia przykłady hipotetycznych konfiguracji twarzy dla 13 powszechnie badanych kategorii emocji. Badania nad ekspresją emocjonalną w psychologii, neuronauce i inżynierii rutynowo wykorzystują fotografie osób pozujących te hipotetyczne ekspresyjne prototypy16,17,18,19,20.

Wszystkie konfiguracje twarzy z wyjątkiem „podziwu” i „pogardy” oparte na konfiguracjach przedstawionych w ref. 12 ; Konfiguracja „awe” oparta na ref. 9 ; Konfiguracja „pogardy” oparta na ref. 96 . Konfiguracje twarzy utworzono w FaceGen (Singular Inversions, Inc., Toronto, ON, Kalifornia), przy czym jednostki AU ustawiono na intensywność 100%, z wyjątkiem przypadków, gdy spowodowałoby to widoczne zniekształcenia — w tych przypadkach jednostki AU ustawiono na intensywność 80%.

W niniejszym artykule przedstawiamy raport z badania przeprowadzonego na dwóch próbach, którego celem było zbadanie zakresu zmienności wewnątrz kategorii i podobieństwa między kategoriami w konfiguracjach twarzy wyrażających emocje. W przeciwieństwie do innych badań zoptymalizowaliśmy ważność ekologiczną, analizując fotografie pozycji twarzy 21 , 22 wykonane przez osoby posiadające funkcjonalną wiedzę na temat emocji: zawodowych aktorów, których sukces w pracy polega na autentycznym przedstawianiu doświadczeń emocjonalnych w filmach, telewizji i teatrze, w taki sposób, że odgrywane przez nich ruchy twarzy są postrzegane jako wiarygodne i o dużej wartości informacyjnej 23 . W jednym z poprzednich powiązanych badań studenci aktorstwa przedstawiali emocje 24 , ale według naszej wiedzy w żadnym badaniu na ten temat nie wykorzystywano jako bodźców póz zawodowych aktorów. W naszym badaniu wykorzystaliśmy 604 z 731 fotografii dostępnych w dwóch tomach Howarda Schatza In Character: Actors Acting 21 i Caught in the Act: Actors Acting 22 jako bodźce w naszym badaniu, wyłączając tylko te zdjęcia, których nie można było przeanalizować, ponieważ dłonie zakryły twarz lub głowa była bardzo pochylona. Aktorzy, którzy zostali sfotografowani do książki, otrzymali szczegółowe, budzące emocje scenariusze, takie jak „To motocyklista wysiadający z baru dla motocyklistów w chwili, gdy facet w porsche wjeżdża tyłem do swojego lśniącego harleya” oraz „Ona konfrontuje się z nią kochanek, który ją odrzucił, i jego żona, gdy wychodzą z restauracji”. (Wszystkie scenariusze zostały napisane przez Howarda Schatza i opublikowane w wyżej wymienionych tomach.) Próba uczestników naszego badania oceniła pisemne scenariusze pod kątem ich zawartości emocjonalnej, co pozwoliło nam przypisać wiele scenariuszy do danej kategorii emocji i w ten sposób zbadać zróżnicowanie wewnątrz kategorii, a także podobieństwa między kategoriami w pozach twarzy aktorów.

W Próbie 1 poprosiliśmy uczestników o ocenę znaczenia emocjonalnego w scenariuszach 604. Każdy z 839 uczestników ocenił sam około 30 scenariuszy, bez zdjęć póz twarzy, używając jednoznacznej 25 skali Likerta , aby wskazać stopień, w jakim scenariusz wywołał wystąpienie 13 kategorii emocji. Wykorzystaliśmy te oceny, aby sklasyfikować każdy scenariusz jako należący do jednej z 13 kategorii emocji wymienionych na ryc. 1 . Scenariusz został zaliczony do danej kategorii emocji na podstawie jego najwyższej mediany oceny 23 ; jeśli dwie lub więcej median było równie wysokich, wybieraliśmy kategorię emocji o najmniejszym rozstępie międzykwartylowym. Ponadto trzech ekspertów zakodowało 604 fotografie pozycji twarzy przy użyciu systemu kodowania działań twarzy (FACS) 26 , który określa zestaw jednostek działania (AU), z których każda reprezentuje ruch jednego lub większej liczby mięśni twarzy. Nie mogliśmy zastosować skomputeryzowanych algorytmów kodowania FACS 27 , 28 , 29 , ponieważ nasi certyfikowani koderzy FACS odkryli, że niektóre jednostki AU były systematycznie błędnie kodowane. Stosując indukcyjną strategię analityczną, najpierw zidentyfikowaliśmy scenariusze i odpowiadające im pozy twarzy, które były ze sobą maksymalnie spójne, stosując metodę grupowania bez nadzoru w połączeniu z obiektywnym kryterium wyboru modelu. Oceny scenariuszy uczestników poddaliśmy hierarchicznej analizie skupień 30 i wybraliśmy model, który optymalizował wiarygodność póz twarzy w danym skupieniu. Silne poparcie dla podstawowej hipotezy emocji można byłoby znaleźć, gdyby w tej analizie odkryto 13 kategorii emocji wraz z proponowanymi konfiguracjami twarzy (jak pokazano na ryc. 1 lub warianty w tabeli uzupełniającej 1 ). Dowody zgodne z hipotezą wrażliwości na kontekst można by znaleźć, gdyby nasza analiza indukcyjna odkryła nowe skupienia 2 , 4 , 31 , 32 o wiarygodności i specyficzności póz twarzy równej lub większej niż ta znaleziona dla 13 kategorii emocji na ryc. 1 .

Aby oszacować wiarygodność i specyficzność pozycji twarzy dla 13 kategorii emocji, wykorzystaliśmy Bayesowskie ramy statystyczne 33, aby sprawdzić, czy zdjęcia przedstawiają aktorów pozujących hipotetyczne konfiguracje twarzy na ryc. 1 (lub dowolne warianty wymienione w tabeli uzupełniającej 1 ) dla scenariusze należące do każdej kategorii. Wybór modelu bayesowskiego umożliwił nam ilościową ocenę dowodów na poparcie szeregu precyzyjnych hipotez dotyczących stopnia wiarygodności i swoistości obserwowanych w naszych danych. Silne poparcie dla hipotezy o emocjach podstawowych można byłoby znaleźć, gdybyśmy zaobserwowali, że aktorzy w ponad 70% przypadków ustalali hipotetyczną konfigurację twarzy dla scenariuszy przypisanych do danej kategorii emocji (wysoka wiarygodność), rzadko natomiast przedstawiali tę konfigurację w przypadku scenariuszy przypisanych do innej emocji kategoria (wysoka specyficzność); kryteria te przyjęto w niedawnym przeglądzie systematycznym przeprowadzonym przez ekspertów naukowych reprezentujących różne tradycje teoretyczne 34 w oparciu o kryteria sugerowane w badaniach nad percepcją emocji przez badaczy podstawowych emocji 35 . Kryteria te posłużyły jako wytyczne do oceny naszych ustaleń (70% i więcej odpowiada dużej rzetelności; 40–69% odpowiada umiarkowanej rzetelności; 20–39% odpowiada słabej rzetelności). Ustalenia, które nie potwierdzałyby podstawowej hipotezy dotyczącej emocji, obejmowały dowody o słabej do umiarkowanej wiarygodności w połączeniu ze słabą swoistością, ponieważ ten wzór sugerowałby, że hipotetyczne konfiguracje twarzy na ryc. 1 nie były prototypowymi wyrazami wybranych kategorii emocji, przynajmniej gdy były przedstawiane przez zawodowych aktorów, takich jak ci na zdjęciach.

Do badania percepcji emocji wprowadzono kryteria klasyfikacji rzetelności i specyficzności, w ramach których uczestnikom prezentowane są fotografie póz twarzy i proszeni są o wywnioskowanie ich znaczenia emocjonalnego poprzez wybranie słowa będącego emocją z listy słów dostarczonej przez eksperymentatora. Dane z badań z wykorzystaniem tej metody wykorzystano jako dowód na uniwersalność ekspresji emocjonalnej, potwierdzając logikę, że ekspresja emocjonalna i zdolność rozpoznawania tych wyrażeń (tj. postrzeganie emocji) prawdopodobnie ewoluowały wspólnie jako zintegrowany system sygnalizacji 36 , 37 . Kontynuując tę wcześniejszą pracę, przetestowaliśmy także postrzeganie emocji na zdjęciach póz twarzy. W próbie 2 uczestnicy oceniali emocjonalne znaczenie każdej pozy, prezentowanej samodzielnie lub w odpowiadającym jej scenariuszu. Każdy z 842 uczestników ocenił samodzielnie około 30 pozycji twarzy, a każdy z 845 uczestników ocenił około 30 par scenariuszy twarzy, w zależności od tego, w jakim stopniu należały one do jednej z 13 kategorii emocji. Oceny te pozwoliły nam sprawdzić, w jakim stopniu uczestnicy wyciągali wnioski o znaczeniu emocjonalnym pozycji twarzy na podstawie samego zdjęcia, w porównaniu do stopnia, w jakim znaczenie emocjonalne było kształtowane przez kontekst – odpowiedni scenariusz pozycji twarzy. Poparcie podstawowej hipotezy o emocjach można by znaleźć, gdyby oceny samych zdjęć (z Próby 2) przewidywały emocjonalne znaczenie póz twarzy w kontekście scenariusza (pary twarz-scenariusz z Próby 2) w równym stopniu jak oceny tylko te scenariusze (z Próby 1). Takie odkrycie sugerowałoby, że struktura (lub morfologia) ruchów twarzy na zdjęciach ma pewne wewnętrzne znaczenie emocjonalne, które wyłoniło się pomimo wszelkich możliwych wpływów kontekstu. Poparcie dla hipotezy wrażliwości na kontekst można by znaleźć, gdyby same oceny emocji w scenariuszach lepiej przewidywały postrzegane emocjonalne znaczenie twarzy w kontekście (pary twarz-scenariusz). Takie odkrycie nawiązuje do innych badań 38, które sugerują, że kontekst przyczynia się do wnioskowania przez odbiorcę o znaczeniu emocjonalnym, wywierając wpływ oprócz, a być może poza, wszelkimi stereotypowymi skojarzeniami emocjonalnymi, jakie mogą wiązać się z ruchami twarzy.

Wyniki

Nienadzorowana analiza skupień ocen emocji uczestników scenariuszy z wiarygodnością póz twarzy wykorzystanych do wyboru modelu

Korzystając z danych z Próbki 1, obliczyliśmy profil emocji dla każdego z 604 scenariuszy, składający się z mediany ocen dla każdej z 13 kategorii emocji (rysunek uzupełniający 2 ). Poddaliśmy parami odległości euklidesowe pomiędzy wszystkimi profilami scenariuszy algorytmowi hierarchicznego grupowania 30, który minimalizował średnie odległości wewnątrz klastrów (szczegółowe informacje można znaleźć w sekcji „Metody”). Każdy ze scenariuszy w danym klastrze został powiązany z odpowiednimi pozami twarzy i obliczyliśmy wyniki dopasowania wewnątrz klastra ( m ) dla każdej pary póz twarzy w każdym klastrze jako liczba aktywowanych jednostek AU wspólnych dla póz, w stosunku do całkowitej liczby aktywowane jednostki AU w obu 9 , jak w równaniu. 1 :

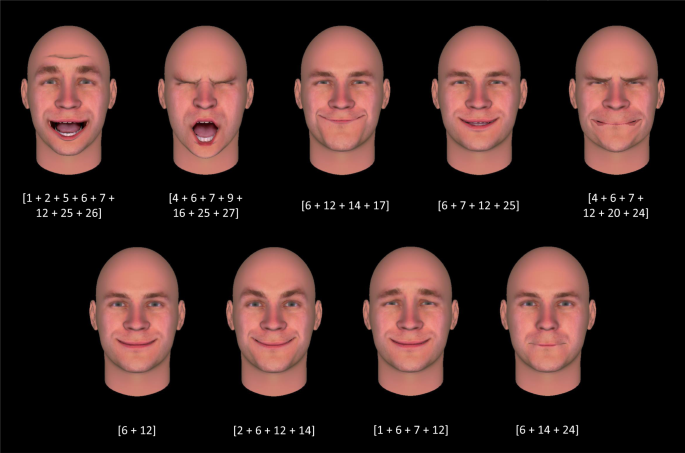

Mnożenie liczby aktywowanych jednostek AU przez dwa w liczniku pozwala uzyskać bardziej zrozumiały zakres wyników dopasowania, który będzie wynosić od 0 do 1, gdzie 1 oznacza całkowitą zgodność, a 0 oznacza całkowitą niezgodność. Mediana wyników dopasowania wewnątrz klastra reprezentowała niezawodność wewnątrz klastra, przy czym wyższe mediany wyników dopasowania wewnątrz klastra wskazują na większą niezawodność wewnątrz klastra. Następnie wykorzystaliśmy wyniki dopasowania wewnątrz klastra w procedurze wyboru modelu w następujący sposób: obliczyliśmy wyniki dopasowania wewnątrz klastra dla każdego możliwego rozwiązania grupowania, począwszy od rozwiązań z jednym do 604 klastrów (rysunek uzupełniający 3 ). Wybraliśmy rozwiązanie o najwyższej medianie wyniku dopasowania wewnątrz klastra, która wyniosła 0,4, co wskazuje średnio na umiarkowaną niezawodność w konfiguracjach AU w klastrze. To rozwiązanie dało 80 klastrów indukcyjnych (rysunek uzupełniający 4 ), z których 34 miało średni wynik dopasowania wewnątrz klastra na poziomie 0, 4 lub wyższym (przedstawiony w tabeli uzupełniającej 3 ). Rysunek 2 przedstawia konfiguracje twarzy odpowiadające przykładowi klastra indukcyjnego; konfiguracje twarzy dla drugiego przykładowego klastra indukcyjnego przedstawiono na dodatkowej ryc. 5 .

Pozy są prezentowane wraz z ich składowymi jednostkami AU; spójne jednostki AU dla tego skupienia wynosiły 6, 7 i 12. Te jednostki AU występują w hipotetycznych konfiguracjach twarzy związanych ze szczęściem i rozrywką (tabela uzupełniająca 1 ). Jednakże powyższe pozy twarzy przedstawiają konfiguracje zidentyfikowane na zdjęciach aktorów przedstawiających scenariusze wywołujące różne kategorie emocji. Powiązane kategorie emocji dla scenariuszy w tej grupie (na podstawie ocen uczestników) to szczęście, zainteresowanie, duma i zaskoczenie. Konfiguracje twarzy utworzono w FaceGen (Singular Inversions, Inc., Toronto, ON, Kalifornia), przy czym jednostki AU ustawiono na intensywność 100%, z wyjątkiem przypadków, gdy spowodowałoby to widoczne zniekształcenia — w tych przypadkach jednostki AU ustawiono na intensywność 80%. Dane źródłowe podano w tabeli uzupełniającej 3 .

Z tych 34 skupień indukcyjnych tylko jeden był podobny do kategorii emocji zaproponowanej w podstawowym ujęciu emocji: przy 11 scenariuszach i medianie wiarygodności wewnątrz skupień wynoszącej 0,4, pozy tego skupienia były umiarkowanie podobne do hipotetycznej konfiguracji twarzy wyrażającej strach, z udziałem AU1 , AU2 i AU25 (była najbliższa konfiguracji opisanej jako 1 + 2 + 5 z lub bez 25, 26 lub 27 39 ). Inne skupienie indukcyjne, z 18 scenariuszami i medianą wiarygodności wewnątrz skupienia wynoszącej 0,4, zawierało pozy, które były umiarkowanie podobne do hipotetycznej konfiguracji twarzy dla kombinacji kategorii strachu i zaskoczenia 40 . Żadne z pozostałych skupień (z których wszystkie miały umiarkowaną niezawodność, z medianą wyników dopasowania w zakresie od 0,4 do 0,67; tabela uzupełniająca 3 ) nie przypominało konfiguracji twarzy hipotetycznych na podstawie podstawowego poglądu na emocje, które zwykle są przedmiotem badań naukowych. Co ważne, wiele klastrów indukcyjnych było bardziej niezawodnych w powiązanych z nimi konfiguracjach twarzy niż 13 podstawowych kategorii emocji na ryc. 1 . Dziesięć z 12 najbardziej wiarygodnych skupień ( m ≥ 0,5) zawierało tylko od dwóch do czterech pozycji. Co więcej, każde skupienie indukcyjne było powiązane z hipotetycznymi konfiguracjami twarzy dla wielu podstawowych kategorii emocji: liczba konfiguracji twarzy, które osiągnęły umiarkowaną rzetelność ( m ≥ 0,4) dla każdego skupienia indukcyjnego była znacznie większa niż jedna, co potwierdza, że zależności te nie wykazały swoistości (Tabela uzupełniająca 4 ). Stwierdzenie to utrzymuje się niezależnie od tego, czy niezawodność obliczono przy użyciu jednostek AU aktywowanych w danym klastrze z medianą intensywności co najmniej umiarkowanej ( M = 4,41, SD = 2,13, t (33) = 9,32, p < 0,001, dwustronny, 95% CI [2,67, 4,16], d = 1,60) lub czy obliczono medianę rzetelności dla jednostek AU o dowolnej intensywności ( M = 4,62, SD = 1,62, t (33) = 13,10, p < 0,001, dwustronny, 95% CI [ 3,05, 4,18], d = 2,25).

Nadzorowana analiza klasyfikacyjna póz twarzy przypisanych do kategorii emocji na podstawie ocen scenariuszy uczestników

Ponownie korzystając z danych z Próby 1, najpierw przypisaliśmy każdy z 604 scenariuszy do jednej z 13 kategorii emocji w oparciu o ich najwyższą medianę oceny emocji. Jeśli wiele kategorii emocji wiązało się z najwyższą medianą oceny, wybraliśmy kategorię z najmniejszym rozstępem międzykwartylowym. Wszelkie pozostałe powiązania zostały zerwane poprzez wybranie kategorii emocji, dla której powiązana z nią pozycja twarzy uzyskała najwyższy wynik dopasowania, jak to teraz wyjaśnimy. Dla każdej kategorii emocji potwierdziliśmy, że ten proces przypisywania odzwierciedlał znacznie wyższą średnią ocenę dla danej kategorii emocji (np. złość) niż dla ocen związanych ze wszystkimi innymi kategoriami emocji, przy użyciu jednokierunkowej analizy ANOVA z planowaną kontrast. Wszystkie uzyskane wartości F i t były istotne przy p < 0,01, dwustronnie, z wyjątkiem zachwytu, dla którego wartość t była istotna przy p < 0,05, ale F nie było istotne (patrz Tabela 1, aby zapoznać się ze statystykami podsumowującymi , Tabela uzupełniająca 6, aby uzyskać szczegółowe informacje).

Kategoria emocji |

Scenariusze liczbowe |

Ocena intensywności |

F |

zm |

Wartość kontrastu |

T |

|---|---|---|---|---|---|---|

Rozrywka |

24 |

2,40 (0,78) |

28,70** |

12, 299 |

25.71 |

16,42** |

Gniew |

128 |

3,04 (0,87) |

144,48** |

12, 1651 |

29.81 |

31,87** |

Groza |

2 |

2,00 (2,83) |

0,77 |

12, 13 |

20.00 |

1,87* |

Pogarda |

11 |

1,82 (0,64) |

17.07** |

12, 130 |

19,59 |

12.05** |

Niesmak |

24 |

2,77 (0,91) |

29,97** |

12, 299 |

27,85 |

14,19** |

Zakłopotanie |

38 |

2,78 (0,98) |

39,34** |

12, 481 |

27.45 |

16,83** |

Strach |

94 |

3,31 (0,82) |

108,29** |

12, 1209 |

34,35 |

31,32** |

Szczęście |

64 |

3,16 (0,80) |

127,29** |

12, 819 |

31.01 |

26.11** |

Odsetki |

63 |

2,63 (0,76) |

86,88** |

12, 806 |

28.27 |

29,33** |

Duma |

19 |

2,42 (1,29) |

21,18** |

12, 234 |

25.18 |

12.08** |

Smutek |

50 |

3,29 (0,89) |

52,74** |

12, 637 |

32.41 |

20.05** |

Wstyd |

9 |

3,50 (0,50) |

22,69** |

12, 104 |

32,67 |

10,45** |

Niespodzianka |

78 |

2,88 (0,70) |

51,44** |

12, 1001 |

28,57 |

22,89** |

Następnie sprawdziliśmy, czy na 604 zdjęciach aktorzy wiarygodnie pozują hipotetyczne konfiguracje twarzy, aby przedstawić scenariusze przypisane do każdej kategorii emocji. Postępując zgodnie z procedurą opisaną we wcześniejszych badaniach dotyczącą oceny wiarygodności9 , obliczyliśmy wynik dopasowania ( m ) dla każdej pozycji twarzy jako liczbę aktywowanych jednostek AU, które stanowią wspólną z hipotetyczną konfiguracją twarzy dla odpowiedniej kategorii emocji, w stosunku do całkowitej liczby aktywowanych Jednostki AU w obu przypadkach (tj. stosując równanie 1 ). Aby poradzić sobie z subtelnymi różnicami w hipotetycznych konfiguracjach twarzy (tabela uzupełniająca 1 ), obliczyliśmy wynik dopasowania między każdą z 604 fotografii a wszystkimi możliwymi hipotetycznymi kombinacjami AU zaproponowanymi dla danej kategorii emocji i wybraliśmy wartość mediany dla każdej. Wybór ten stanowił kompromis pomiędzy przyjęciem maksymalnego wyniku dopasowania (liberalna decyzja w przypadku testowania hipotezy podstawowej emocji) a przyjęciem minimalnego wyniku dopasowania (liberalna decyzja w przypadku testowania hipotezy wrażliwości kontekstowej).

Ze względu na fakt, że kodowaliśmy zdjęcia statycznych pozycji twarzy, nie byliśmy w stanie zakodować żadnych jednostek AU, które wymagałyby ruchu. W rezultacie nie byliśmy w stanie zakodować żadnej jednostki AU w hipotetycznych konfiguracjach twarzy dla dumy (Head Up, AU53; Eye Down, AU64) i wstydu (Head Down, AU54; Eye Down, AU64). Byliśmy w stanie zakodować jedynie częściowe konfiguracje dla rozrywki (pomijając Head Up, AU53) i zawstydzenia (pomijając Head Down, AU54; Eye Down, AU64). Aby złagodzić ten problem, oparliśmy się na symulacjach w celu oszacowania wiarygodności dla tych kategorii emocji. Na przykład jedna z proponowanych konfiguracji twarzy wyrażających zażenowanie obejmuje jednostki AU 51, 54 i 64 9 . Nasze symulacje pozwoliły nam oszacować, jaka byłaby niezawodność, gdybyśmy byli w stanie zakodować te jednostki AU. W 1000 iteracjach każdą brakującą jednostkę AU zakodowano jako obecną – indywidualnie lub w połączeniu – dla danej pozycji twarzy w oparciu o medianę wartości bazowej wszystkich zakodowanych jednostek AU, która wynosiła 0,104. Do symulacji wykorzystano medianę wartości bazowej wszystkich zakodowanych jednostek AU, ponieważ zakłada się, że niekodowane dynamiczne jednostki AU występują z w przybliżeniu tą samą częstotliwością, co zakodowane jednostki AU. Stanowi to oparty na danych sposób symulowania jednostek AU, który jest zakotwiczony we wzorcach aktywności obecnych w bardziej ogólnie odgrywanych przedstawieniach. Jako oszacowanie pozycji twarzy wybraliśmy medianę wyniku dopasowania z 1000 symulacji.

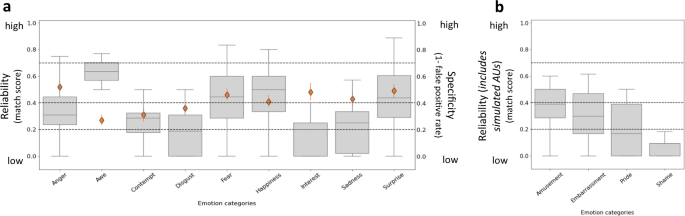

Rozkłady wyników dopasowania przedstawiono na ryc. 3 w postaci szarych wykresów prostokątnych i wąsów. We wszystkich kategoriach emocji większość median wyników dopasowania spadła poniżej 0,4, co wskazuje, że hipotetyczne konfiguracje emocji na ryc. 1 zaobserwowano ze słabą wiarygodnością. Zaobserwowano, że jedynie podziw, strach, szczęście i zaskoczenie miały umiarkowaną niezawodność (przy medianie wyników dopasowania odpowiednio 0,63, 0,44, 0,50 i 0,44; szczegóły patrz tabela uzupełniająca 7 ). Pozy twarzy odpowiadające przykładowym scenariuszom strachu i złości przedstawiono na dodatkowej ryc. 6, ilustrującej różnorodność zaobserwowanych konfiguracji twarzy.

a Kategorie emocji, dla których można było zakodować wszystkie jednostki akcji (AU). b Kategorie emocji, dla których symulowano jednostki AU, biorąc pod uwagę, że dynamicznych jednostek AU nie można zakodować na podstawie zdjęć. Wiarygodność: Szare wykresy z wąsami pokazują rozkład wyników dopasowania między pozami twarzy i hipotetycznymi konfiguracjami twarzy dla każdej kategorii emocji. Każdy wykres przedstawia wartości maksymalne i minimalne jako wąsy, rozstęp międzykwartylowy jako pionową długość pudełka, a medianę jako poziomą linię wewnątrz pudełka. Poziome linie przerywane oznaczają stopień niezawodności na podstawie kryteriów z wcześniejszych badań 35 : brak (0 < 0,2), słaby (0,2 < 0,4), umiarkowany (0,4 < 0,7), wysoki (0,7 ≤ 1). Specyfika: pomarańczowe romby przedstawiają odsetek pozycji twarzy ( N = 604) odpowiadających hipotetycznej konfiguracji twarzy dla każdej kategorii emocji, które zaobserwowano w odpowiedzi na scenariusze sklasyfikowane w tej samej kategorii emocji, obliczonej jako uzupełnienie współczynnika wyników fałszywie dodatnich , tak że wyższe wyniki wskazują na większą specyficzność. Słupki błędów reprezentują szacowane przedziały wiarygodności. Nie byliśmy w stanie obliczyć specyfiki kategorii emocji: rozbawienia, zawstydzenia, dumy lub wstydu, ponieważ nie mieliśmy informacji o dynamicznych jednostkach AU, które stanowią część hipotetycznych konfiguracji twarzy dla tych kategorii. Dane źródłowe podano w tabelach uzupełniających 7 i 10 .(�mi^)

Stosując procedurę wyboru modelu bayesowskiego 41 , 42 , porównaliśmy prawdopodobieństwo obserwacji obecnych danych w ramach hipotezy zerowej (brak lub słaba wiarygodność) z prawdopodobieństwem obserwacji danych w ramach alternatywnych hipotez o umiarkowanej lub wysokiej wiarygodności (tabele uzupełniające 8 i 9 ). Wyniki te w niewielkim stopniu potwierdzają hipotezę, że zawodowi aktorzy uwzględnieni w naszej próbce zdjęć wiarygodnie ustawili hipotetyczne konfiguracje twarzy, aby przedstawić przypadki odpowiednich kategorii emocji, zgodnie z interpretacją, że zamiast tego przedstawiali szeroką gamę konfiguracji twarzy zależnych od kontekstu. Jedna kategoria (podziw) zapewniła słabsze poparcie dla kontekstowej hipotezy zerowej, sugerując jednak, że aktorzy stawiali hipotetyczne konfiguracje twarzy z umiarkowaną wiarygodnością. Aby zapewnić solidność tych wyników, sprawdziliśmy, że obowiązują one przy zastosowaniu podejścia wieloświatowego 43 do oceny wiarygodności (patrz strony 22–23 informacji uzupełniających). Podejście to jest cenne, ponieważ wykazuje maksymalną przejrzystość wpływu procedur analitycznych, w ramach których podejmowano szereg teoretycznie uzasadnionych decyzji (tabela uzupełniająca 14 ). Co najważniejsze, wieloświat pozwala nam sprawdzić, czy główne ustalenia dotyczą szeregu wyborów analitycznych, w tym wyczerpania wszystkich potencjalnych kombinacji między nimi, unikając w ten sposób pułapek związanych z rozwidlaniem się ścieżek. Ogólne mediany wartości rzetelności wynikające z podejścia wieloświatowego ( M = 0,37, SD = 0,10) nie różniły się od podanych powyżej ( M = 0,32, SD = 0,15), t (12) = 1,71, p ≤ 0,11, dwustronne, 95% CI [−0,01; 0,11], d = 0,49. Szczegóły tych wyników (patrz strony 22–23 informacji uzupełniających ) są również cenne przy rozpakowywaniu, które decyzje analityczne są krytyczne dla osiągnięcia określonych wyników, w tym wyników, które bardziej potwierdzają podstawową hipotezę emocji w porównaniu z hipotezą wrażliwości na kontekst. W rezultacie nasza analiza wieloświatowa może służyć jako przejrzysty przewodnik dla przyszłych replikacji i rozszerzeń tej pracy.

Niektóre scenariusze – zwłaszcza te przypisane do kategorii rozbawienia, podziwu, pogardy i dumy – zostały ocenione jako mniej intensywnie sugestywne, w związku z czym średnie średnie oceny emocji w tych kategoriach były niskie. Aby sprawdzić, czy hipotetyczne konfiguracje twarzy będą częściej pojawiać się w scenariuszach wywołujących większą intensywność emocjonalną, powtórzyliśmy naszą analizę wiarygodności na podzbiorze 444 scenariuszy (i odpowiadających im pozach twarzy), których średnia mediana intensywności wynosiła co najmniej 3 (silnie) w skali od 1 (nieznacznie) do 4 (intensywnie) ( szczegóły można znaleźć w tabeli uzupełniającej 11 ). Analiza ta potwierdziła, że zdjęcia nie pokazywały aktorów pozujących hipotetyczne konfiguracje twarzy w scenariuszach o dużej intensywności ( M = 0,30, SD = 0,16) niż w przypadku wszystkich scenariuszy ( M = 0,32, SD = 0,15), t (12) = 0,92, p ≤ 0,38, dwustronny, 95% CI [-0,03, 0,08], d = 0,22 (patrz ryc. uzupełniająca 7 i tabela uzupełniająca 12 ).

Aby sprawdzić, czy zdjęcia przedstawiają aktorów pozujących w sposób konkretny, obliczyliśmy odsetek wyników fałszywie dodatnich ( dla każdej z 13 hipotetycznych konfiguracji twarzy na ryc. 1 , jak w równaniu 2 :

gdzie ke to liczba póz pasujących do hipotetycznej konfiguracji twarzy dla danej kategorii, które zaobserwowano w pozach mających na celu wywołanie scenariuszy, które zostały ocenione jako intensywnie wywołujące przypadki innych kategorii emocji (np. grymas na twarzy konfiguracje zaobserwowane dla scenariuszy nieprzypisanych do kategorii gniewu), a to całkowita liczba pozycji twarzy pasujących do tej konfiguracji twarzy we wszystkich kategoriach (np. wszystkich konfiguracji twarzy z grymasem). Na przykład pozycja twarzy, która wiarygodnie pasuje (tj. m ≥ 0,4) do konfiguracji twarzy z grymasem, zostanie uznana za fałszywie pozytywną w przypadku złości, jeśli powiązany z nią scenariusz otrzyma średnią ocenę intensywności złości mniejszą niż 2, ale średnią ocenę intensywności smutku większa niż 2. Swoistość obliczono dla dziewięciu z 13 konfiguracji twarzy na Ryc. 1 . Nie byliśmy w stanie ocenić specyfiki rozbawienia, zawstydzenia, dumy i wstydu, ponieważ nie mogliśmy w sposób rozsądny określić, kiedy hipotetyczne konfiguracje twarzy dla tych kategorii (w tym dynamicznych jednostek AU) zaobserwowano na zdjęciach przypisanych do innych kategorii.

Jednostronne testy dwumianu Bayesa wykazały, że dziewięć wskaźników fałszywie dodatnich było znacznie wyższych niż te, które można by zaobserwować przypadkowo (przy zastosowaniu progu 0,11 lub 1 z 9; patrz tabela uzupełniająca 10 ). Specyficzność była umiarkowana dla wszystkich kategorii z wyjątkiem podziwu, pogardy i wstrętu (ryc. 3 ). Możliwe, że obliczenia specyficzności zostały zawyżone; nie było możliwe oszacowanie dolnej granicy współczynnika wyników fałszywie dodatnich, ponieważ wymagałoby to założenia, że pominięte jednostki AU zostały aktywowane dla wszystkich pozycji twarzy we wszystkich kategoriach emocji. Niemniej jednak najwyższy współczynnik specyficzności dotyczył gniewu i wynosił 0,52, co odpowiada odsetkowi wyników fałszywie dodatnich wynoszącym 0,48.

Powtórzyliśmy naszą analizę, wykorzystując podzbiór 444 scenariuszy o wysokiej intensywności i obliczyliśmy specyfikę póz twarzy. Spowodowało to znaczny wzrost odsetka wyników fałszywie pozytywnych we wszystkich dziewięciu kategoriach emocji (przy użyciu scenariuszy o dużej intensywności [ M = 0,77, SD = 0,11], przy użyciu wszystkich scenariuszy [ M = 0,58, SD = 0,09], t (8) = 17,58, p <0,001, dwustronny, 95% CI [0,16, 0,21], d = 7,77; patrz dodatkowa ryc. 8 ). Jednostronne testy dwumianu Bayesa dodatkowo potwierdziły, że każdy odsetek wyników fałszywie dodatnich był znacznie wyższy, niż można by się spodziewać przypadkowo (tabela uzupełniająca 13 ). Możliwe, że te obserwacje miały miejsce, ponieważ scenariusze o dużej intensywności wywoływały przypadki więcej niż jednej kategorii emocji (tj. były bardziej złożone emocjonalnie). Aby zbadać tę możliwość, obliczyliśmy wskaźnik złożoności, korzystając z ocen intensywności emocji. Indeks ten reprezentował stopień, w jakim scenariusze zostały sklasyfikowane, wśród uczestników, jako wywołujące przypadki więcej niż jednej kategorii emocji, gdzie obecność kategorii emocji operacjonalizowano jako medianę oceny intensywności wynoszącą co najmniej 1 (nieznacznie); wskaźnik złożoności nie oznaczał stopnia, w jakim scenariusz został oceniony jako wywołujący u uczestników przypadki wielu kategorii emocji, ponieważ tej ostatniej statystyki nie można było oszacować na podstawie obecnych danych. Scenariusze o wysokiej intensywności ( n = 444) były rzeczywiście bardziej złożone (tj. otrzymały oceny w większej części kategorii emocji; M = 0,32, SD = 0,12) niż pozostałe scenariusze ( n = 160, M = 0,21, SD = 0,11 ), t (602) = 10,06, p < 0,001, dwustronny, 95% CI [0,09, 0,13], d = 0,93.

Aby zapewnić solidność tych wyników, sprawdziliśmy, że dotyczyły one ocen uczestników z Próby 2 (patrz strona 21 informacji uzupełniających ) oraz podczas stosowania podejścia wieloświatowego do oceny specyficzności (patrz strony 23–24 informacji uzupełniających ). Ogólna mediana wartości specyficzności wynikająca z analizy wieloświatowej ( M = 0,36, SD = 0,11) była znacząco niższa niż podana powyżej ( M = 0,42, SD = 0,09), t (8), = −3,27, p ≤ 0,01, dwa- ogonowany, 95% CI [−0,09, −0,02], d = 1,18, co zapewnia silniejsze wsparcie dla hipotezy wrażliwości na kontekst.

Ocena kontekstowego zróżnicowania ocen emocji uczestników na zdjęciach póz twarzy

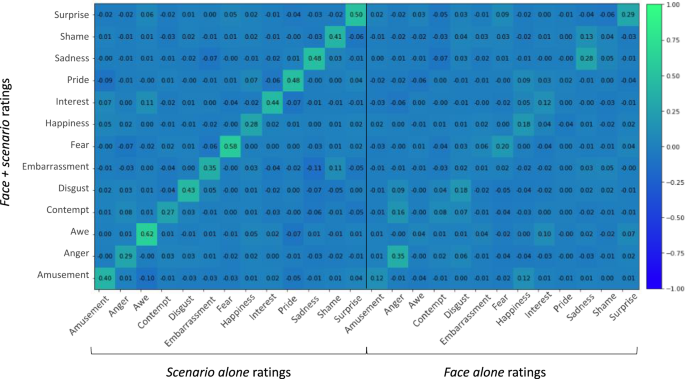

Obliczyliśmy profile emocji dla każdej z 604 fotografii na podstawie ocen uczestników z Próby 2, którzy ocenili każdą pozę twarzy osobno (tj. oceny samej twarzy), reprezentując medianę wniosków uczestników na temat znaczenia emocjonalnego bez odpowiedniego scenariusza jako kontekstu. Każdy profil zawierał 13 średnich ocen kategorii emocji. Następnie obliczyliśmy profile emocji dla każdej z 604 par scenariuszy twarzy, korzystając z ocen uczestników z Próby 2, którzy ocenili każde zdjęcie wraz z odpowiadającym mu scenariuszem (tj. twarz + ocena scenariusza), reprezentując medianę wniosków na temat znaczenia emocjonalnego pozycji twarzy w kontekście. Zbadaliśmy korelację rzędu zerowego między tymi dwoma zestawami profili emocji, a także ich korelację z profilami emocji dla ocen samego scenariusza z Próbki 1 (rysunek uzupełniający 10 ). Profile emocji twarzy w kontekście (tj. twarz + oceny scenariusza) były silniej przewidywane na podstawie ocen samego scenariusza (mediana r = 0,84, średnia r = 0,74) niż na podstawie samych ocen twarzy (mediana r = 0,66, średnia r = 0,56), t (1,1068) = 9,30, p < 0,001, dwustronny, 95% CI [0,14, 0,23], d = 0,57. To, że sam scenariusz i oceny twarzy + scenariusza nie były doskonale skorelowane, sugeruje jednak, że twarz nie była nieistotna dla ocen uczestników. Oceny samej twarzy i samego scenariusza były umiarkowanie skorelowane (mediana r = 0,37, średnia r = 0,32), co wskazuje, że wnioski emocjonalne na temat samej twarzy i samego scenariusza mogą niezależnie przewidywać pewne rozbieżności we wnioskach emocjonalnych na temat twarzy w kontekście. Seria wielokrotnych regresji liniowych wykazała, że samo emocjonalne znaczenie scenariuszy lepiej przewidywało emocjonalne znaczenie twarzy w kontekście (twarze + scenariusze), przy umiarkowanej do dużej wielkości efektu. Półczęściowe współczynniki regresji przedstawiono na rys. 4 i reprezentują one proporcję całkowitej wariancji w ocenach twarzy + scenariusza, które zostały jednoznacznie przewidziane odpowiednio na podstawie mediany ocen samego scenariusza i mediany ocen samej twarzy. W przypadku wszystkich ocen emocji z wyjątkiem jednej (oceny złości) rozmiary efektu dla ocen samego scenariusza były większe niż dla ocen samych twarzy (patrz przekątne lewej i prawej macierzy).

Półczęściowe współczynniki regresji dla ocen mediany samego scenariusza (kolumny w lewej macierzy) i ocen samych twarzy (kolumny w prawej macierzy) w przypadku regresji względem ocen twarzy i scenariusza (wiersze). Jak wskazuje kolorowy pasek po prawej stronie rysunku, bardziej dodatnie współczynniki pojawiają się w odcieniach zieleni, podczas gdy neutralne i bardziej ujemne współczynniki pojawiają się w odcieniach niebieskiego. Dane źródłowe są dostarczane w postaci pliku danych źródłowych.

Częściowe współczynniki regresji przedstawiono na dodatkowej ryc. 11 i pokazują, że znaczenie emocjonalne samych scenariuszy przewidywało wyjątkową wariancję w znaczeniu emocjonalnym par twarzy + scenariuszy, która nie została uwzględniona przez emocjonalne znaczenie samych twarzy, podczas gdy emocjonalne znaczenie samych twarzy było mniej skuteczne w przewidywaniu wyjątkowej rozbieżności w znaczeniu emocjonalnym par twarz + scenariusz, która nie została uwzględniona na podstawie emocjonalnego znaczenia samych scenariuszy. Odkrycia te wskazują, że emocjonalne znaczenie par twarz + scenariusz jest w dużej mierze powiązane z emocjonalnym znaczeniem samych scenariuszy, a w bardzo nielicznych przypadkach pozy twarzy same w sobie wpływają na emocjonalne znaczenie par twarz + scenariusz. uwzględnia się wariancję wynikającą ze scenariuszy.

Łącznie odkrycia te sugerują, że gdy fotografię przedstawiającą pozę twarzy profesjonalnego aktora oglądano w kontekście wywołującego scenariusza, emocjonalne znaczenie konfiguracji twarzy różniło się w porównaniu z tym, które wywnioskowano bez kontekstu. Jedna z możliwych interpretacji tych wyników jest taka, że znaczenie emocjonalne wywnioskowane z tego kontekstu wywarło silny wpływ na emocjonalne znaczenie pozycji twarzy – to znaczy, że pozycja twarzy miała niewielki wpływ na emocjonalne znaczenie scenariusza. Aby porównać złożoność ocen scenariuszy i twarzy, porównaliśmy proporcje kategorii emocji wywołanych przez każdy z nich. Ustaliliśmy, że scenariusze zostały ocenione jako bardziej złożone ( M = 0,29, SD = 0,13) niż twarze ( M = 0,11, SD = 0,08), t (1206) = −29,36, p < 0,001, dwustronny, nie założono równych wariancji , 95% CI [−0,19, −0,17], d = 1,67. Oznacza to, że złożoność znaczenia emocjonalnego wynika również ze scenariusza związanego z pozą twarzy.

Dyskusja

W niniejszym badaniu sprawdziliśmy na fotografiach, jak zawodowi aktorzy, którzy mają funkcjonalną wiedzę w zakresie przekazywania emocji, pozują twarze, aby przedstawić przykłady złości, smutku, wstrętu i innych kategorii emocji w różnych scenariuszach. Stosując podejście polegające na grupowaniu bez nadzoru, które obejmowało oceny uczestników dotyczące znaczeń emocjonalnych scenariuszy oraz zdjęcia konfiguracji twarzy pozowanych przez aktorów w celu przekazania tych znaczeń, znaleźliśmy indukcyjne kategorie emocji o umiarkowanej wiarygodności w obrębie kategorii, które, ogólnie rzecz biorąc, nie przypominały zdroworozsądkowe kategorie emocji, od których zaczęliśmy i które były przedmiotem badań w większości opublikowanych badań na temat emocji. Stosując metodę nadzorowanej klasyfikacji, w której wykorzystano oceny scenariuszy uczestników w celu przypisania zdjęć do kategorii emocji, odkryliśmy, że pozy twarzy aktorów nie dostarczyły mocnych dowodów na istnienie prototypowych wyrazów twarzy dla tych kategorii: podczas gdy przypadki niektórych kategorii emocji zostały przedstawione z umiarkowaną wiarygodnością i swoistość, swoistość ta zmniejszyła się w przypadku scenariuszy o wysokiej intensywności w każdej kategorii. Umiarkowana rzetelność i umiarkowana specyficzność mogą początkowo wydawać się empirycznym potwierdzeniem podstawowej hipotezy dotyczącej emocji na łamach opublikowanego artykułu, ale wartości te są znacznie poniżej poziomu wiarygodności i specyficzności potrzebnego ludzkim postrzegającym do pewnego wnioskowania o obecności emocji w życiu codziennym 34 , naruszając jedno z głównych uzasadnień podstawowej hipotezy emocjonalnej 11 . Zamiast tego nasze odkrycia są bardziej spójne z hipotezą, że ludzie przekazują emocje za pomocą twarzy w sposób wrażliwy na kontekst, jak wyraźnie zakładają konstrukcjonistyczne, funkcjonalistyczne i ekologii behawioralnej podejścia do emocji.

Niniejsze ustalenia łączą się z innymi niedawnymi podsumowaniami dowodów empirycznych34 i sugerują, że grymasy, uśmiechy i inne konfiguracje twarzy należą do większego , bardziej zróżnicowanego repertuaru znaczących sposobów, w jakie ludzie poruszają twarzą, aby wyrazić emocje. W związku z tym odkrycia te sugerują, że hipotetyczne konfiguracje twarzy na ryc. 1 nie są ekspresyjnymi prototypami (tj. nie są najczęstszymi lub typowymi przykładami swoich kategorii) 44 . Zamiast tego te konfiguracje twarzy mogą odzwierciedlać zachodnie stereotypy: nadmiernie uproszczone przedstawienia, które są uważane za bardziej odpowiednie niż w rzeczywistości. Kiedy badania oferują pojedyncze słowo będące emocją lub zubożony scenariusz dla danej kategorii emocji i proszą uczestników o upozowanie wyrazu twarzy wyrażającego tę emocję, uczestnicy (którzy nie są przeszkoleni w przedstawianiu emocji w celach zawodowych) konsekwentnie tworzą konfiguracje podobne do stereotypów w Ryc. 1 9 , 45 . W takich badaniach zakłada się, że jeden egzemplarz kategorii emocji jest w dużej mierze podobny do innego, dlatego też pojedynczy egzemplarz emocji jest reprezentatywny dla wszystkich wystąpień danej kategorii. Jednak zawodowi aktorzy okazują emocje w sposób bardziej uwzględniający kontekst, zgodnie z badaniami mierzącymi spontanicznie wytwarzane ruchy twarzy w rzeczywistych sytuacjach, które wykazały, że wywoływanie ekspresji emocjonalnej jest umiejscowione i zmienne 46 .

Niniejsze badanie, choć przeprowadzone w kontrolowanych warunkach, ma jednak ważne implikacje w świecie rzeczywistym. Na przykład analiza zdjęć wykazała, że w tej próbie aktorzy krzywili się przez około 30% przypadków, udając złość, co jest zgodne z wynikami metaanalizy, że ludzie krzywią się przez około 30% przypadków, gdy są wściekli34; tak słaba wiarygodność oznacza, że przez większość czasu ludzie wyrażają złość w inny sposób (co odpowiada wysokiemu odsetkowi wyników fałszywie ujemnych w przypadku niepoprawnego wnioskowania o gniewie na podstawie ruchów twarzy). Ze wszystkich przypadków, gdy aktorzy skrzywili się, w 50% przypadków ich pozy kojarzono ze scenariuszem gniewu, a w 50% przypadków ich pozy kojarzono ze scenariuszem o innym znaczeniu emocjonalnym; ta umiarkowana specyficzność odpowiada 50% odsetkowi wyników fałszywie dodatnich (błędne wnioskowanie, że ktoś jest zły). Taki wzorzec nie wspierałby adaptacyjnej komunikacji międzyludzkiej i podejmowania decyzji.

Uznanie zmienności sposobów wyrażania emocji przez ludzi jest ważne w wielu dziedzinach życia. Na przykład algorytmy widzenia komputerowego zostały zaprojektowane tak, aby rzekomo „wykrywać” złość, szczęście, smutek itd. na twarzach za pomocą grymasów, uśmiechów, zmarszczek i innych konfiguracji twarzy, które przypuszcza się, że są uniwersalnym wyrazem tych kategorii emocji 28 , 47 . Opieranie się na stereotypowych konfiguracjach może pozwolić na dokładne przewidywanie tylko wtedy, gdy istnieje niewielka zmienność ekspresji pomiędzy instancjami różnych kategorii. Jeżeli jednak w obrębie kategorii występuje umiarkowana do dużej zmienność w połączeniu z umiarkowanym do dużego podobieństwem między kategoriami – jak sugerują niniejsze ustalenia – wówczas wskazuje to na dalsze problemy praktyczne i etyczne przy stosowaniu tych kategorii algorytmy w rzeczywistych kontekstach predykcyjnych 34 .

Zgodnie z naszymi ustaleniami, rosnąca liczba badań wykazała, że przejawy emocji mogą nie być wyrażane za pomocą ruchów twarzy o wystarczającej wiarygodności i swoistości, aby można je było uznać za przejawy diagnostyczne 34 . Naukowcy odkryli, że najnowsze dane metaanalityczne z badań mających na celu sprawdzenie hipotezy podstawowych emocji sugerują, że hipotetyczne konfiguracje twarzy przedstawione na ryc. 1 są obserwowane ze słabą wiarygodnością 46 , 48 : przy użyciu 131 rozmiarów efektu wybranych z 76 badań, w których wzięło udział łącznie 4487 uczestników ( a) średnia wielkość efektu wynosząca 0,31 dla korelacji pomiędzy obecnością hipotetycznej konfiguracji twarzy wyrażającej złość, wstręt, strach, szczęście, smutek lub zaskoczenie a miarą danej emocji oraz (b) średnia wielkość efektu wynosząca 0,22 dla odsetek przypadków, w których hipotetyczna konfiguracja twarzy była obserwowana podczas doświadczenia emocjonalnego należącego do jednej z tych kategorii. Ustalenia te potwierdzają dowody na zróżnicowanie ekspresji emocjonalnej u różnych ludzi, kontekstów i kultur 34 . Podstawowy pogląd na emocje wyjaśnia tę zmienność jako wynik różnorodnych wpływów, które są przyczynowo niezależne od emocji, ale oddziałują na przejaw ich ekspresji, takich jak akcenty kulturowe 9 , 14 , zasady okazywania 49 , strategie regulacji emocji 50 , fluktuacje stochastyczne 50 , różnice indywidualne w budowie mięśni twarzy 51 , 52 , czy błąd pomiaru. Niemniej jednak fakt, że hipotetyczne konfiguracje twarzy na ryc. 1 mają niską wartość ekologiczną jako prototypowe ekspresje emocjonalne, nie jest zaskakujący, jeśli weźmiemy pod uwagę ich pochodzenie: nie zostały one odkryte empirycznie poprzez obserwację ludzi wyrażających emocje podczas codziennych epizodów emocji, ale zamiast tego zostały ustalone Karola Darwina 53 na podstawie rysunków anatoma Charlesa Bella 54 i fotografii neurologa Guillaume-Benjamina-Amanda Duchenne’a 55 . Konfiguracje te zostały później przyjęte przez naukowców w XX wieku jako prawdziwe 34 , 56 , 57 i potwierdzone przy użyciu wysoce ograniczonej metody badawczej, która – jak wykazano od lat 90. XX w. – zwiększa poparcie dla hipotezy, że są to uniwersalne, wyraziste prototypy 4 , 34 , 58 , 59 , 60 .

Należy zauważyć, że chociaż konfiguracje twarzy zakładane w ramach podstawowego poglądu na emocje nie są wyrazami prototypowymi i należą do szerszego repertuaru wyrażeń emocjonalnych, kilka konfiguracji wykazało większą niezawodność i specyficzność niż inne. Pozy twarzy w kategoriach podziwu, strachu, szczęścia i zaskoczenia wykazały umiarkowaną niezawodność, a pozy w kategoriach strachu, szczęścia i zaskoczenia również wykazały umiarkowaną specyficzność (której nie można było ocenić pod kątem podziwu). Możliwe, że kategorie te są powiązane z bardziej ograniczonymi zestawami stereotypowych zachowań twarzy, takich jak uśmiechanie się ze szczęścia. Możliwe jest również, że stereotypy te mogły być szczególnie widoczne podczas tworzenia statycznych póz twarzy w kontrolowanych warunkach. Z tej perspektywy obecne odkrycia mogą w rzeczywistości zapewnić poziom wsparcia dla podstawowego poglądu na emocje, którego nie można by zaobserwować w bardziej naturalistycznych warunkach.

W niniejszym badaniu sprawdziliśmy również, czy ludzie postrzegający będą wnioskować o emocjach na podstawie pozowanych konfiguracji twarzy w wystarczająco rzetelny i konkretny sposób, gdy metody eksperymentalne umożliwią obserwację zmienności. Powtarzając wcześniejsze ustalenia 34 , odkryliśmy, że emocjonalne znaczenie pozycji twarzy (w tym przypadku zdjęcie zawodowego aktora) było wrażliwe na kontekst związany z twarzą, w związku z czym informacje emocjonalne dostępne w scenariuszu przeważały nad informacjami przekazywanymi przez morfologię samych ruchów twarzy. Odkrycia te podkreślają znaczenie istniejących dowodów na to, że kontekst nie tylko moderuje postrzeganie uniwersalnych wyrażeń emocjonalnych: kontekst ma potężny wpływ na postrzeganie emocji 31 , 38 , 61 , 62 , 63 — nawet na wnioski emocjonalne na podstawie hipotetycznych przedstawionych konfiguracji twarzy na ryc. 1 23 , 32 , 64 , 65 . Informacje kontekstowe dominują w postrzeganiu emocji na twarzach, zarówno gdy scenariusze są częstymi sytuacjami 66 , jak i wtedy, gdy są bardziej niejednoznaczne niż oceniana konfiguracja twarzy 67 . Słabsze korelacje między emocjonalnym znaczeniem scenariuszy a konfiguracją twarzy mogą również wynikać z różnic w postrzeganej złożoności emocjonalnej, takich jak te, które zaobserwowaliśmy w naszym zestawie bodźców. Różnice te – choć mogą wydawać się niekorzystne dla podstawowej hipotezy dotyczącej emocji – w większym stopniu odzwierciedlają bogactwo rzeczywistych doświadczeń emocjonalnych niż abstrakcyjne i uproszczone scenariusze zwykle stosowane w badaniach nad percepcją emocji (np. „Zostałeś obrażony, i jesteś z tego powodu bardzo zły”, „Właśnie zmarł Twój kuzyn i jest Ci bardzo smutno”) 9 .

Wyraz emocji na twarzy może być szczególnie zdominowany przez informacje kontekstowe w sytuacjach intensywnych emocjonalnie. W bieżącym badaniu zaobserwowaliśmy znaczny spadek specyficzności póz twarzy aktorów, gdy ograniczyliśmy naszą analizę do scenariuszy o dużej intensywności – obserwacja szczególnie zaskakująca w świetle podstawowej hipotezy dotyczącej emocji, zgodnie z którą zdarzenia o dużej intensywności powinny z większym prawdopodobieństwem wywołać produkować prototypowe mimiki 68 , 69 . Odkrycie to jest zgodne z najnowszymi dowodami wskazującymi, że duża intensywność emocjonalna jest powiązana z ruchami twarzy, które nie są specyficzne dla poszczególnych kategorii emocji, ani nawet o pozytywnej lub negatywnej wartościowości 38 , 70 . Jedną z możliwości jest to, że scenariusze o dużej intensywności, które wykorzystaliśmy, były bardziej złożone emocjonalnie, w związku z czym mogły wywoływać bardziej zróżnicowane pozy twarzy. Odkryliśmy, że scenariusze o wysokiej intensywności otrzymały oceny w większej części kategorii emocji niż scenariusze o niższej intensywności, co potwierdza tę hipotezę. Inną możliwością jest to, że scenariusze o dużej intensywności w rzeczywistości zachęcają do ruchów twarzy i innych ekspresyjnych zachowań, które stereotypowo odpowiadają innym kategoriom emocji (np. zmarszczka nosa z przyjemności, a nie z obrzydzenia, płacz z radości, a nie ze smutku). Te dymorficzne wyrażenia mogą być skutecznym sposobem komunikowania intensywności emocji 71 , 72 , a jednocześnie składają się z ruchów twarzy, których nie można rozróżnić bez dodatkowego kontekstu.

Rola kontekstu w ekspresji emocjonalnej została dodatkowo potwierdzona przez nasze analizy skupień bez nadzoru. Kiedy poddaliśmy profile ocen emocji uczestników scenariuszy algorytmowi hierarchicznego grupowania, odkryliśmy, że wiele z nowo odkrytych wzorców ruchów twarzy było bardziej wiarygodnych niż hipotetyczne konfiguracje twarzy na ryc. 1 . Odkrycia te sugerują, że wiarygodne konfiguracje twarzy odzwierciedlają podobne zestawy cech psychologicznych (uchwyconych w profilach emocji; patrz strona 14 informacji uzupełniających ) i że te zestawy cech psychologicznych są bogatsze niż te uchwycone przez pojedyncze angielskie słowo emocjonalne. W związku z tym stawiamy hipotezę, że aktorzy reagowali bardziej wiarygodnie za pomocą twarzy ze względu na podobieństwo informacji kontekstowych zawartych w każdym scenariuszu. Zamiast jednak szczegółowego mapowania konfiguracji twarzy i scenariuszy, stawiamy hipotezę, że jednostki – zawodowi aktorzy lub nie – wykorzystują wcześniejsze doświadczenia, aby wytworzyć różnorodny zakres ruchów twarzy w oparciu o kontekst wewnętrzny i zewnętrzny. Ruchy twarzy nie są łączone liniowo czy addytywnie z elementarnych kategorii wyrazu; konfiguracja wyłania się w wyniku wielowarstwowych i interaktywnych procesów mających na celu osiągnięcie celów komunikacyjnych. Aby przetestować te hipotezy, przyszłe badania mogą systematycznie konstruować bodźce w celu ujawnienia specyficznych cech kontekstowych, które mogą napędzać ruchy twarzy pozerów. Na przykład scenariusze można opisać w oparciu o różne wymiary oceny 73 , 74 lub w kategoriach bardziej szczegółowych kategorii emocji (np. autentyczna duma vs. pycha) 75 , 76 . Wewnętrzny kontekst pozera można opisać na podstawie tła kulturowego, osobistych doświadczeń, a nawet kontekstu fizycznego, takiego jak postawa 2 , 31 , 77 , 78 . Wiadomo również, że wewnętrzny kontekst odbiorcy wpływa na jego wnioski dotyczące znaczenia emocjonalnego w ruchach twarzy 79 i również powinien zostać uchwycony.

Obecne ustalenia podkreślają potrzebę zmiany projektu eksperymentu: zamiast badania twarzy w (prawie) izolacji, ekologicznie uzasadnione podejście do zrozumienia wytwarzania i postrzegania ekspresji emocjonalnej wymaga metod badawczych, które wyraźnie modelują kontekst, w tym kontekst czasowy 80 , co pozwala do obserwacji zmienności. W niniejszych badaniach wykorzystaliśmy scenariusze i zdjęcia dostarczone przez Actors Acting tomy 21 , 22 , ale bodźce te zostały ograniczone na kilka ważnych sposobów. Po pierwsze, pozowane fotografie nie pozwoliły na zbadanie ważnych informacji zawartych w czasowej dynamice ruchów twarzy, w tym ich względnego czasu, szybkości, czasu trwania i sekwencji 81 , 82 , 83 . Ponieważ aktorzy wykonywali ruchy twarzy w odpowiedzi na bogate, sugestywne scenariusze, niektóre statyczne pozy były stosunkowo trudniejsze do zakodowania, co skutkowało wartościami wiarygodności między koderami, które były niższe od idealnych, mimo że były zgodne z opublikowanymi badaniami wykorzystującymi nieukierunkowane pozy 84 , 85 (patrz rozdział „Metody”). Po drugie, ponieważ pozerzy byli zawodowymi aktorami, mogli zostać również rozpoznani przez uczestników. Istnieją dowody sugerujące, że ludzie lepiej rozpoznają twarze celów, które dobrze znają86 , chociaż obecnie nie ma dowodów na to, że znajomość wpływa na oczekiwania co do konfiguracji twarzy celów. Po trzecie, te scenariusze, zdjęcia i uczestnicy zostali zaczerpnięci ze stosunkowo jednolitego kontekstu kulturowego (patrz sekcja „Metody”), tak że odkrytych klastrów indukcyjnych nie można postrzegać jako reprezentatywnych dla repertuarów twarzy spoza Ameryki Północnej. Jednakże wcześniejsze badania sugerują , że uwzględnienie dodatkowych kontekstów kulturowych prawdopodobnie zaniżyłoby szacunki wiarygodności i swoistości 34,58 . Strategia doboru doboru próby zastosowana przez nas podczas rekrutacji uczestników przez Internet może również ograniczać możliwość uogólnienia wyników, chociaż ustalenia z takich prób często pokrywają się z próbkowaniem reprezentatywnym na poziomie krajowym 87 . Wreszcie, poproszenie uczestników o ocenę scenariuszy i zdjęć przy użyciu wybranego zestawu słów związanych z emocjami, zamiast pozwalać im na swobodne etykietowanie bodźców, mogło sztucznie ograniczyć ich wnioski na temat znaczenia emocjonalnego; bezpłatne etykietowanie prawdopodobnie również obniżyłoby szacunki dotyczące wiarygodności i swoistości 59,88,89. Niemniej jednak nawet skromne zmiany zaproponowane w naszym projekcie badawczym – wykorzystanie zdjęć profesjonalnych aktorów pozujących według konfiguracji twarzy i wybranie więcej niż jednego przypadku każdej badanej kategorii emocji – wystarczyły, aby wykazać, że ekspresja emocjonalna jest znacznie bardziej zależna od kontekstu i zmienna niż tradycyjnie. przypuszczalny.

Metody

Uczestnicy

Uczestnikami Próby 1 było 839 osób (473 kobiety; mediana wieku = 35, rozstęp międzykwartylowy = 28, 45 lat) z adresami IP w USA, rekrutowanymi w serwisie Amazon Mechanical Turk. Aby zmaksymalizować jakość odpowiedzi, wybrano jedynie uczestników sklasyfikowanych jako mistrzowie na podstawie wysokiego współczynnika akceptacji Human Intelligence Tasks (HIT) firmy Amazon, ponieważ wykazano, że zwracają oni większą uwagę na kierunki badania i przestrzegają ich 90 . Uczestnikami próby 2 było 1687 osób (963 kobiety; mediana wieku = 35 lat, rozstęp międzykwartylowy = 29, 45 lat). Uczestnicy Próby 1 byli rekrutowani oddzielnie od uczestników Próby 2, których losowo przydzielano do jednego z dwóch zadań, jak opisano poniżej. Szczegółowe dane demograficzne uczestników dla obu próbek wygody online przedstawiono w tabeli uzupełniającej 15 . Gromadzenie danych odbywało się zgodnie ze wszystkimi obowiązującymi przepisami etycznymi dotyczącymi badań z udziałem ludzi, a wszyscy uczestnicy wyrazili świadomą zgodę przed udziałem. Protokół badania został zatwierdzony przez Instytucjonalną Komisję Rewizyjną na Northeastern University.

Jako platforma crowdsourcingowa Mechanical Turk umożliwiła rekrutację dużej grupy uczestników w Stanach Zjednoczonych, co umożliwiło ocenę postrzegania bodźców fotograficznych i scenariuszowych w kontekście kulturowym, w którym zostały one opracowane, jak opisano poniżej. Wielkości próbek zaplanowano tak, aby osiągnąć odpowiednią moc statystyczną na poziomie pozycji, tak aby każdy bodziec był oceniany przez 40 uczestników. Wszystkie dane zebrano w marcu 2018 r. Spośród 2526 uczestników w próbach 1 i 2 459 rozpoczęło, ale nie ukończyło zadania online. Jednakże, jak szczegółowo opisano poniżej, ponieważ bodźce były losowe, oceny były od siebie niezależne. Dzięki temu mogliśmy zachować wszystkie dane dotyczące ocen; żadne dane nie zostały wyłączone z analizy.

Bodźce

Scenariusze i odpowiadające im pozy twarzy zostały zaczerpnięte z dwóch książek: In Character: Actors Acting 21 , która dostarczyła 218 par scenariusz-pozy twarzy, oraz Caught in the Act: Actors Acting 22 , która dostarczyła 513 par scenariusz-pozy twarzy łącznie 731 par. Wykluczyliśmy 127 pozycji twarzy, których nie można było zakodować w systemie FACS (np. dłonie zakrywały twarz lub mocno pochylona głowa), pozostawiając do zbadania 604 scenariusze i odpowiadające im pozycje twarzy. Te pozy zostały stworzone przez 155 różnych aktorów działających w anglojęzycznym kontekście kulturowym Ameryki Północnej. Jak opisano we wstępie do In Character: Actors Acting : „Każdy aktor otrzymał [kilka scenariuszy, z których każdy mógł zawierać] kierunek, postać do zagrania, scenę, a czasami nawet dialog. Robiono zdjęcia, podczas których każdy z aktorów twórczo opracowywał swoją rolę” (s. 7). Wszystkie scenariusze zostały napisane przez Howarda Schatza. W niektórych przypadkach scenariusze zawierały określone słowa wyrażające emocje (np. „zły”, „rozbawiony”, „zaskoczony”). Jednak aktorzy zostali poinstruowani, aby przedstawić scenariusz w całej jego złożoności, a nie jakąś konkretną docelową emocję. Przewodnik po identyfikacji bodźców w opublikowanych tomach udostępniany jest w trwałym repozytorium danych prowadzonym przez Centrum Otwartej Nauki pod adresem https://osf.io/m32ha/ . Przycięliśmy wszystkie pozy obejmujące tułów i/lub ramiona, aby uwzględnić tylko głowę i szyję. Lekko obróciliśmy głowy w pozach twarzy, które nie były pionowe, aby ułatwić ich kodowanie i uniknąć problemów percepcyjnych 91 . Wszystkie pozy twarzy zostały przeskalowane w skali szarości, aby zminimalizować wpływ koloru na percepcję 92 .

Oceny emocji

Uczestnicy przeszli 30 prób oceniających, podczas których losowo losowano bodźce i prezentowano je pojedynczo. W próbie 1 wszyscy uczestnicy ocenili samodzielnie scenariusze. W Próbie 2 uczestnicy zostali losowo przydzieleni do oceny samych twarzy lub par twarzy i scenariusza. Ponieważ bodźce losowano losowo, możliwe jest, że poszczególnym uczestnikom przedstawiono wiele twarzy tego samego pozera (tj. tożsamości), ale z niskim prawdopodobieństwem, biorąc pod uwagę liczbę możliwych tożsamości (155).

W każdej próbie oceniającej uczestnicy wskazywali, w jakim stopniu bodziec wywołał każdą z 13 emocji zaproponowanych do diagnostycznej konfiguracji twarzy 9 , 74 , 93 : złość, rozbawienie, podziw, pogarda, wstręt, zawstydzenie, strach, szczęście, zainteresowanie, duma , smutek, wstyd i zaskoczenie. Uczestnicy wystawiali swoje oceny za pomocą jednoznacznej skali Likerta 25 , mającej na celu zmniejszenie częstości występowania niepewnych odpowiedzi. Dla każdego słowa będącego emocją uczestnicy najpierw wskazali, czy dana osoba w bodźcu doświadczyła danej emocji (tj. pozer, bohater scenariusza), wybierając „TAK” lub „NIE”. Jeżeli TAK, to uczestnicy wskazywali jego intensywność w skali od 1 (nieznacznie) do 4 (intensywnie). Uczestnicy mogli ocenić bodziec jako „neutralny” i dowolnie oznaczyć go wybranymi przez siebie słowami dotyczącymi emocji. Powiedziano im wyraźnie, że bodźce mogą wywoływać więcej niż jedną emocję. Dodatkowy rys. 12 pokazuje przykład próby oceny scenariusza. Kolejność prezentacji 13 słów związanych z emocjami została losowo dobrana, aby zmniejszyć błąd w odpowiedziach podczas oceny. Każdy bodziec został oceniony przez 40 uczestników. Na koniec sesji uczestnicy przekazali informacje demograficzne, w tym rasę, wiek, płeć i pierwszy język.

Kodowanie FACS

Trzej koderzy z certyfikatem FACS zakodowali 604 pozycje twarzy. Twarze różniły się wiekiem i kątem ułożenia, co utrudniało osiągnięcie wystarczającej wiarygodności przy użyciu najnowocześniejszych algorytmów automatycznego wykrywania. Ponieważ złotym standardem, według którego oceniane są te algorytmy, są ludzie-programiści, zdecydowaliśmy się na solidniejsze podejście do kodowania FACS. Kodery kodowane tylko dla jednostek AU opisujących ruchy górnej i dolnej części twarzy (AU1 do AU27; nie ma AU3). Nie kodowaliśmy jednostek AU powyżej 27, ponieważ dotyczą one głównie ruchów oczu i głowy, a informacji nie mogliśmy zweryfikować na podstawie bodźców. Zakodowano brak (0) lub obecność (1) każdej jednostki AU i jeśli była obecna, jednostce AU przypisano jeden z pięciu poziomów intensywności od A (najniższa intensywność; reprezentacja numeryczna = 1) do E (najwyższa intensywność; reprezentacja numeryczna = 5 ). Nie uwzględniliśmy jednostronnego kodowania jednostek AU, ponieważ występowało ono w mniej niż 1% przypadków w przypadku wszystkich kodowanych jednostek AU.

Oceniliśmy niezawodność między koderami parami, jak we wcześniejszych badaniach 9 , poprzez obliczenie wyników dopasowania parami ( m ) pomiędzy koderami, jak opisano w równaniu. 1 powyżej. Tam, gdzie więcej niż jedna para koderów oceniała daną pozę twarzy, używaliśmy mediany wartości wyniku dopasowania. Uzyskaliśmy medianę wyniku 0,71 (przedział międzykwartylowy: 0,54; 0,80). Wartości wiarygodności między koderami według kategorii emocji przedstawiono w Tabeli 2 . Wartości te są zgodne z innymi opublikowanymi badaniami, w których stosowano nieukierunkowane pozy, w których pozujący nie zostali poinstruowani ani przeszkoleni w zakresie ruchów twarzy. Na przykład poprzednie badania udokumentowały w bazie danych RU-FACS średnie wartości kappa wynoszące 0,70 dla sekwencji pozycji nieukierunkowanych 85 , przy poszczególnych jednostkach AU w zakresie od 0,00 do 0,64 84 . Uzyskane przez nas wartości niezawodności między koderami mieszczą się również w zakresie pozycji skierowanych, które zazwyczaj są łatwiejsze do zakodowania. Na przykład poprzednie badania udokumentowały średnie wartości kappa pomiędzy 0,75 (klatka po klatce) a 0,82 (wierzchołek) dla sekwencji ukierunkowanych póz w bazie danych Extended Cohn-Kanade (CK+) 94 , z indywidualnymi jednostkami AU w zakresie od 0,04 do 0,9284 .

| Kategoria emocji | Numeruj pozy twarzy | Liczba oceniona pod kątem ICR | Mediana ICR | Rozstęp międzykwartylowy ICR |

|---|---|---|---|---|

| Rozrywka | 24 | 15 | 0,67 | 0,55, 0,80 |

| Gniew | 128 | 23 | 0,71 | 0,52, 0,76 |

| Groza | 2 | 2 | 0,76 | 0,71, 0,81 |

| Pogarda | 11 | 10 | 0,84 | 0,47, 0,98 |

| Niesmak | 24 | 17 | 0,71 | 0,57, 0,91 |

| Zakłopotanie | 38 | 15 | 0,73 | 0,54, 0,76 |

| Strach | 94 | 20 | 0,57 | 0,50, 0,72 |

| Szczęście | 64 | 28 | 0,74 | 0,57, 0,82 |

| Odsetki | 63 | 17 | 0,75 | 0,62, 0,83 |

| Duma | 19 | 13 | 0,67 | 0,40, 0,80 |

| Smutek | 50 | 21 | 0,53 | 0,36, 0,75 |

| Wstyd | 9 | 9 | 0,75 | 0,67, 0,89 |

| Niespodzianka | 78 | 21 | 0,77 | 0,67, 0,89 |

Analiza

Przegląd naszego głównego kierunku analizy przedstawiono na dodatkowej ryc. 13 . Aby przeprowadzić naszą analizę grupowania bez nadzoru, najpierw poddaliśmy profile emocji dla każdego z 604 scenariuszy (rysunek uzupełniający 2 ) analizom grupowania hierarchicznego w SciPy v1.5.2 (scipy.cluster.hierarchy) 30 przy użyciu algorytmów i metryk odległości wymienionych w Tabela uzupełniająca 2 . Wybraliśmy algorytm i metryki odległości, które dały najskuteczniejsze rozwiązanie grupowania, wskazane przez rozwiązanie o najwyższym współczynniku korelacji kofenetycznej ( c) . Współczynnik ten odzwierciedla stopień, w jakim rozwiązanie grupujące wiernie zachowuje odległość między parami profili emocji 95 , tak że wyższa wartość wskazuje lepszą skuteczność danego podejścia grupującego w odkrywaniu grup scenariuszy o podobnych profilach emocji. Stosując metrykę odległości euklidesowej, metoda uśredniania i metoda centroidy dały rozwiązania o równie wysokiej wydajności ( c = 0,66). Podczas gdy metoda centroidów maksymalizuje odległości między centroidami, metoda uśredniania minimalizuje średnią odległość parami między elementami tego samego klastra. Wybraliśmy metodę uśredniania zamiast metody centroidów, ponieważ najbardziej zależało nam na odkryciu skupień zdefiniowanych na podstawie wewnątrzgrupowego podobieństwa póz twarzy, a wartości odstające mogły zawyżać współczynniki korelacji 95 .

Następnie określiliśmy optymalną liczbę skupień w profilach emocji. Możliwe były 604 rozwiązania (rozwiązanie z jednym skupieniem, rozwiązanie z dwoma skupieniami, itd.). W ramach danego rozwiązania obliczyliśmy medianę wyniku dopasowania ( m ) dla póz twarzy powiązanych ze scenariuszami w każdym skupieniu, a następnie obliczyliśmy ogólną medianę wyniku dopasowania dla tego rozwiązania. Klastry posiadające tylko jednego członka nie były brane pod uwagę, ponieważ nie można było obliczyć wyników dopasowania parami.

Aby przetestować niezawodność konfiguracji twarzy związanych z każdym odkrytym klastrem, porównaliśmy każdy z 34 klastrów indukcyjnych o umiarkowanej niezawodności (przedstawionej w tabeli dodatkowej 3 ) z konfiguracjami twarzy, które zgodnie z podstawowym poglądem na emocje 9 , 40 , 96 , 97 , wyrażaj 13 kategorii emocji opisanych w tabeli dodatkowej 1 i ryc. 1 . Obliczyliśmy wynik dopasowania ( m ) pomiędzy wariantami każdej konfiguracji twarzy, co do której zakładano, że wyraża rozbawienie, podziw, złość itp., a wspólna konfiguracja AU każdego klastra indukcyjnego wybrała maksymalny wynik dopasowania. Założyliśmy, że wszystkie pominięte jednostki AU (powyżej 27) zostały aktywowane w pozycjach twarzy, tworząc w ten sposób górną granicę wiarygodności dla dotkniętych kategorii emocji, takich jak rozbawienie, zawstydzenie, duma i wstyd. Ponadto obliczyliśmy wyniki meczów za pomocą dwóch metod. W pierwszej metodzie wynik dopasowania porównywał jednostki AU, które zostały aktywowane z co najmniej umiarkowaną medianą intensywności dla danego klastra z hipotetycznymi konfiguracjami twarzy. W drugiej metodzie obliczyliśmy wyniki dopasowania dla wszystkich jednostek AU dla danego klastra (niezależnie od intensywności) w odniesieniu do hipotetycznych konfiguracji twarzy, a następnie zidentyfikowaliśmy medianę wyniku dopasowania. Aby przetestować specyficzność, policzyliśmy liczbę hipotetycznych konfiguracji mających co najmniej umiarkowaną niezawodność ( m ≥0,4) dla każdego klastra indukcyjnego (tabela uzupełniająca 4 ).

Podsumowanie raportowania

Więcej informacji na temat projektu badań można znaleźć w podsumowaniu raportowania badań przyrodniczych, do którego link znajduje się w tym artykule.

Dostępność danych

Dane źródłowe wszystkich odpowiednich tabel i rycin są dostarczane w postaci pliku danych źródłowych, publicznie dostępnego w repozytorium prowadzonym przez Centrum Otwartej Nauki pod adresem https://osf.io/m32ha/ . Do artykułu załączono dane źródłowe.

Dostępność kodu

Dane analizowano głównie przy użyciu języka Python w wersji 3.6.10; skrypty napisane w notatniku Jupyter w wersji 5.5.0 wykorzystywały algorytmy z zestawów narzędzi open source w standardowym pakiecie Anaconda, w tym Pandas v1.0.1, NumPy v1.19.2, Seaborn v0.11.0, SciPy v1.5.2 i Sklearn v0.23.2. Podzbiór analiz dodatkowych przeprowadzono w wersji MATLAB 2018b (The MathWorks, Inc., Natick, MA, USA). Skrypty i instrukcje do wszystkich analiz są publicznie dostępne w repozytorium prowadzonym przez Centrum Otwartej Nauki pod adresem https://osf.io/m32ha/ .

Bibliografia

-

Barrett, LF Rozwiązywanie paradoksu emocji: kategoryzacja i doświadczanie emocji. Osobisty. Towarzystwo Psychol. Obj. 10 , 20–46 (2006).

-

Barrett, LF Czy Darwin mylił się co do wyrażania emocji? Aktualny Wskazówki Psychol. Nauka. 20 , 400–406 (2011).

-

Barrett, LF Teoria skonstruowanych emocji: aktywne wnioskowanie dotyczące interocepcji i kategoryzacji. Towarzystwo poznanie Oddziaływać. Neurologia. 12 , 1–23 (2017).

-

Russell, JA, Bachorowski, JA i Fernandez-Dols, JM Wyraz emocji na twarzy i głosie. Annu. Ks. Psychol. 54 , 329–349 (2003).

-

Anderson, DJ i Adolphs, R. Ramy badania emocji u różnych gatunków. Komórka 157 , 187–200 (2014).

-

Campos, JJ, Mumme, D., Kermoian, R. i Campos, RG Funkcjonalistyczna perspektywa natury emocji. Jpn. J. Res. Emota. 2 , 1–20 (1994).

-

Fridlund, AJ In The Science of Facial Expression (red. Fernández-Dols, J.-M. i Russell, JA) 77–92 (Oxford University Press, 2017).

-

Barrett, LF i Finlay, BL Koncepcje, cele i kontrola zachowań związanych z przetrwaniem. Aktualny Opinia. Zachowaj się. Nauka. 24 , 172–179 (2018).

-

Cordaro, DT i in. Uniwersalia i różnice kulturowe w 22 wyrażeniach emocjonalnych w pięciu kulturach. Emocje 18 , 75–93 (2018).

-

Ekman, P. i Cordaro, DT Co należy rozumieć przez nazywanie emocji podstawowymi. Emota. Obj. 3 , 364–370 (2011).

-

Shariff, AF i Tracy, JL. Do czego służą wyrażanie emocji? Aktualny Wskazówki Psychol. Nauka. 20 , 395–399 (2011).

-

Keltner, D., Sauter, D., Tracy, JL i Cowen, AS Ekspresja emocjonalna: postępy w podstawowej teorii emocji. J. Zachowanie niewerbalne. 43 , 133–160 (2019).

-

Tooby, J. i Cosmides, L. Przeszłość wyjaśnia teraźniejszość: adaptacje emocjonalne i struktura środowisk przodków. Etol. Sociobiol. 11 , 375–424 (1990).

-

Elfenbein, HA, Beaupré, M., Lévesque, M. i Hess, U. W stronę teorii dialektu: różnice kulturowe w ekspresji i rozpoznawaniu pozowanej mimiki. Emocja 7 , 131–146 (2007).

-

Galati, D., Scherer, KR i Ricci-Bitti, PE Dobrowolny wyraz emocji na twarzy: porównanie osób niewidomych od urodzenia z koderami normalnie widzącymi. J. Osobisty. Towarzystwo Psychol. 73 , 1363–1379 (1997).

-

Ekman, P. i Friesen, WV Zdjęcia afektu twarzy (Consulting Psychologists Press, Palo Alto, Kalifornia, 1976).

-

Lundqvist, D., Flykt, A. i Öhman, A. Karolinska reżyserowane twarze emocjonalne – KDEF (Wydział Neurologii Klinicznej, Szpital Karolinska, Sztokholm, 1998).

-

Ma, DS, Correll, J. i Wittenbrink, B. Baza danych twarzy w Chicago: bezpłatny zestaw bodźców twarzy i dane normujące. Zachowaj się. Rozdzielczość Metody 47 , 1122–1135 (2015).

-

Mollahosseini, A., Hasani, B. i Mahoor, MH Affectnet: baza danych zawierająca wyraz twarzy, wartościowość i obliczanie pobudzenia w naturze. W IEEE Transactions on Affective Computing (2017).

-

Tottenham, N. i in. Zestaw mimiki NimStim: oceny nieprzeszkolonych uczestników badania. Psychiatria Res. 168 , 242–249 (2009).

-

Schatz, H. i Ornstein, BJ W charakterze: aktorzy działający (Bulfinch Press, 2006).

-

Schatz, H., Edwards, E. i Ornstein, BJ Przyłapany na gorącym uczynku: aktorzy działający (Glitterati Incorporated, 2013).

-

Carroll, JM i Russell, JA Wyraz twarzy w hollywoodzkim przekazie emocji. J. Osobisty. Towarzystwo Psychol. 72 , 164–176 (1997).

-

Gosselin, P., Kirouac, G. i Doré, FY Komponenty i rozpoznawanie wyrazu twarzy w przekazywaniu emocji przez aktorów. J. Osobisty. Towarzystwo Psychol. 68 , 83–96 (1995).

-

Russell, J. i Carroll, J. O dwubiegunowości pozytywnego i negatywnego afektu. Byk psychologiczny. 125 , 3–30 (1999).

-

Ekman, PE, Friesen, WV i Hager, JC Ludzka twarz 77–254 (Salt Lake City, 2002).

-

Afektywna. Affectiva SDK , https://www.affectiva.com/science-resource/affdex-sdk-a-cross-platform-realtime-multi-face-expression-recognition-toolkit/ (2018).

-

Benitez-Quiroz, CF, Srinivasan, R. & Martinez, AM EmotioNet: dokładny algorytm działający w czasie rzeczywistym do automatycznego dodawania adnotacji do miliona wyrazów twarzy na wolności. W 2016 r. Konferencja IEEE na temat widzenia komputerowego i rozpoznawania wzorców (CVPR) 5562–5570, https://doi.org/10.1109/CVPR.2016.600 (2016).

-

Jaiswal, S. i Valstar, M. Głębokie uczenie się dynamicznego wyglądu i kształtu jednostek akcji twarzy. W 2016 r. Zimowa konferencja IEEE na temat zastosowań widzenia komputerowego, WACV 2016 , https://doi.org/10.1109/WACV.2016.7477625 (2016).

-

Virtanen, P. i in. SciPy 1.0: podstawowe algorytmy obliczeń naukowych w Pythonie. Nat. Metody 17 , 261–272 (2020).

-

Barrett, LF, Mesquita, B. i Gendron, M. Kontekst w percepcji emocji. Aktualny Wskazówki Psychol. Nauka. 20 , 286–290 (2011).

-

Gendron, M., Mesquita, B. i Barrett, LF w Oxford Handbook of Cognitive Psychology (red. Reisberg, D.) 379–389 (Oxford University Press, 2013).

-

Hoijtink, H., Mulder, J., van Lissa, C. i Gu, X. Poradnik dotyczący testowania hipotez przy użyciu współczynnika Bayesa. Psychol. Metody 24 , 539–556 (2019).

-

Barrett, LF, Adolphs, R., Marsella, S., Martinez, A. i Pollak, S. Ponowne rozważenie wyrażeń emocjonalnych: wyzwania związane z wnioskowaniem o emocjach na podstawie ruchów ludzkiej twarzy. Psychol. Nauka. Interes publiczny 20 , 1–68 (2019).

-

Haidt, J. & Keltner, D. Kultura i wyraz twarzy: metody otwarte pozwalają znaleźć więcej ekspresji i gradient rozpoznawania. poznanie Emota. 13 , 225–266 (1999).

-

Ekman, P., Friesen, WV i Ellsworth, P. Emocja w ludzkiej twarzy: wytyczne dotyczące badań i przegląd wyników (Permagon, 1972).

-

Jack, RE, Sun, W., Delis, I., Garrod, OG i Schyns, PG Cztery, a nie sześć: ujawnianie kulturowo powszechnych wyrazów twarzy wyrażających emocje. J. Exp. Psychol. Gen. 145 , 708–730 (2016).

-

Aviezer, H., Trope, Y. i Todorov, A. Sygnały ciała, a nie wyraz twarzy, rozróżniają intensywne emocje pozytywne i negatywne. Nauka 338 , 1225–1229 (2012).

-

Ekman, P. i Friesen, Podręcznik kodowania działań twarzy WV (FACS) (Consulting Psychologists Press, San Francisco, 1984).

-

Du, S., Tao, Y. i Martinez, AM Złożone wyrazy twarzy wyrażające emocje. Proc. Natl Acad. Nauka. USA 111 , E1454 – E1462 (2014).

-

Quintana, DS i Williams, DR Bayesowskie alternatywy dla powszechnych testów istotności hipotezy zerowej w psychiatrii: nietechniczny przewodnik wykorzystujący JASP. BMC Psychiatry 18 , 1–8 (2018).

-

Rouder, JN, Speckman, PL, Sun, D., Morey, RD i Iverson, G. Bayesowskie testy t akceptacji i odrzucenia hipotezy zerowej. Psychonomiczny byk. Obj. 16 , 225–237 (2009).

-

Steegen, S., Tuerlinckx, F., Gelman, A. i Vanpaemel, W. Zwiększanie przejrzystości poprzez analizę wieloświatową. Perspektywa. Psychol. Nauka. 11 , 702–712 (2016).

-

Murphy, GL Wielka księga pojęć (MIT Press, 2002).

-

Elfenbein, HA i Ambady, N. O uniwersalności i specyfice kulturowej rozpoznawania emocji: metaanaliza. Psychol. Byk. 128 , 203–235 (2002).

-

Duran, JI i Fernández-Dols, JM Czy emocje powodują przewidywany wyraz twarzy? Metaanaliza badań nad związkiem między ekspresją a emocjami. Przedruk na https://psyarxiv.com/65qp7 (2018).

-

Benta, K.-I. & Vaida, M.-F. W stronę rzeczywistych systemów rozpoznawania wyrazu twarzy. Oblicz. inż. 15 , 93–102 (2015).

-

Duran, JI, Reisenzein, R. i Fernández-Dols, JM In The Science of Facial Expression (red. Fernández-Dols, JM i Russell, JA) 107–129 (Oxford University Press, 2017).

-

Matsumoto, D. Podobieństwa kulturowe i różnice w zasadach wyświetlania. Motyw. Emota. 14 , 195–214 (1990).

-

Roseman, IJ Zachowania emocjonalne, cele emocjonalne, strategie emocjonalne: Wiele poziomów organizacji integruje zmienne i spójne reakcje. Emota. Obj. 3 , 1–10 (2011).

-

Farahvash, MR i in. Anatomiczne różnice w mięśniach środkowej części twarzy i zmarszczce nosowo-wargowej: badanie 52 sekcji półtwarzowych świeżych zwłok perskich. Chirurg estetyczny. J. 30 , 17–21 (2010).

-

Shimada, K. i Gasser, RF Zmiany w mięśniach twarzy pod kątem ust. Clin. Anat. 2 , 129–134 (1989).

-

Darwin, C. Wyraz emocji u człowieka i zwierząt (1872).

-

Bell, C. Eseje o anatomii ekspresji w malarstwie (Longman, Hurst, Rees i Orme, 1806).

-

Duchenne, G.-B. Mechanizm ludzkiej mimiki (Cambridge University Press, 1990/1862).

-

Gendron, M. i Barrett, LF W obliczu przeszłości: historia twarzy w badaniach psychologicznych nad percepcją emocji. Nauka. Ekspresja twarzy 6 , 45–66 (2017).

-

Widen, SC i Russell, JA Rozpoznawanie przez dzieci wstrętu u innych. Psychol. Byk. 139 , 271–299 (2013).

-

Gendron, M., Crivelli, C. i Barrett, LF Nowe spojrzenie na uniwersalność: różnorodność w rozumieniu wyrazu twarzy. Aktualny Wskazówki Psychol. Nauka. 27 , 211–219 (2018).

-

Hoemann, K. i in. Kontekst ułatwia wykonanie klasycznego, międzykulturowego zadania dotyczącego postrzegania emocji. Emocja 19 , 1292–1313 (2019).

-

Russell, JA Kultura i kategoryzacja emocji. Psychol. Byk. 110 , 426–450 (1991).

-

de Gelder, B. In Handbook of Emotions (red. Barrett, LF, Lewis, M. i Haviland-Jones, JM) Ch. 28, 483–494 (Guildford Publications, 2016).

-

Hess, U. i Hareli, S. In The Science of Facial Expression (red. Fernandez-Dols, JM i Russell, JA) 375–396 (Oxford University Press, 2017).

-

Wieser, MJ i Brosch, T. Twarze w kontekście: przegląd i systematyzacja wpływów kontekstowych na afektywne przetwarzanie twarzy. Przód. Psychol. 3 , 1–13 (2012).

-

Hess, U., Blaison, C. i Kafetsios, K. Ocena wyrazu emocji na twarzy w kontekście: wpływ kultury i orientacji na samokonstrukcję. J. Bezczasownik. Zachowaj się. 40 , 55–64 (2016).

-

Kayyal, M., Widen, S. i Russell, JA Kontekst ma większą moc, niż nam się wydaje: wskazówki kontekstowe zastępują wskazówki dotyczące twarzy, nawet w przypadku wartościowości. Emocja 15 , 287 (2015).

-

Carrera-Levillain, P. i Fernandez-Dols, J.-M. Twarze neutralne w kontekście: ich znaczenie emocjonalne i funkcja. J. Bezczasownik. Zachowaj się. 18 , 281–299 (1994).

-

Carroll, JM i Russell, JA Czy mimika sygnalizuje określone emocje? Ocenianie emocji na podstawie twarzy w kontekście. J. Osobisty. Towarzystwo Psychol. 70 , 205–218 (1996).